Настройка и проверка файлов robots.txt и sitemap.xml

17 июня 2025

Что это и зачем?

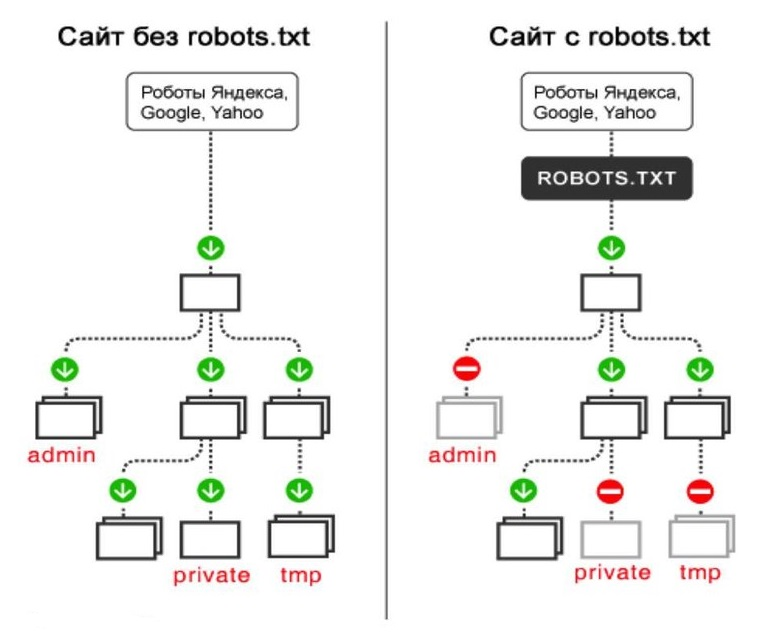

- robots.txt — файл управления индексацией, который подсказывает поисковым роботам, какие разделы сайта не стоит включать в индекс. При этом директивы не блокируют само сканирование и анализ страниц, а лишь предотвращают их появление в выдаче.

- sitemap.xml — техническая «карта» сайта, содержащая список всех ключевых URL. Её используют в первую очередь те боты, которые не рендерят страницы и не переходят по всем ссылкам, чтобы не упустить важные разделы при обходе.

Что даст клиенту?

- Поисковые системы будут тратить своё «время» (краулинговый бюджет) на нужные страницы, а не на мусорные или служебные.

- Новые и обновлённые страницы быстрее попадут в индекс благодаря чёткой карте сайта.

Краулинговый бюджет — это ограничение на количество страниц, которые поисковик готов просканировать на сайте.

Что будет, если пропустить?

- В выдаче появятся ненужные или дублированные страницы, а важные могут не оказаться проиндексированными.

- Появятся скрытые «ловушки» в виде незаметных ошибок индексации, которые со временем съедят значительную часть трафика.

Другие записи

17 июня 2025

Какие работы существуют по SEO продвижению

Перечень работ, которые могут вам пригодиться

17 июня 2025

Первичный SEO-аудит сайта

Первичный SEO-аудит сайта. Что это такое? Какие проблемы решает? Что будет, если не делать?

17 июня 2025

Анализ конкурентов и ниши

Анализ конкурентов и ниши. Что это такое? Какие проблемы решает? Что будет, если не делать?

17 июня 2025

Парсинг сайта и мониторинг отчетов вебмастеров

Парсинг сайта и мониторинг отчетов вебмастеров. Что это такое? Какие проблемы решает? Что будет, если не делать?

17 июня 2025

Формирование или корректировка структуры сайта

Структура сайта. Что это такое? Какие проблемы решает? Что будет, если не делать?

Оставьте заявку, и мы ответим на все ваши вопросы

Мы рядом и готовы помочь

Почему стоит выбрать нас?

Ответов: 5

✨ 24 года на рынке digital-решений

⛳ 20+ специалистов в команде

✅ 900+ реализованных проектов

⚙️ 40+ проектов в работе

⚒️ 7 лет — средний срок сотрудничества